L’AI Act è ormai una realtà. Le regole del gioco per l’intelligenza artificiale in Europa sono state scritte. Molti la vedono come un mostro burocratico, una complessità aggiuntiva, la “fine dell’innovazione!”, ciò che ci condannerà come Europa all’arretratezza.

Calma. Respira.

La verità è un’altra. In un mondo dove tutti corrono a casaccio con l’AI, l’Europa non ha messo un freno a mano, ha messo un navigatore GPS. Avere regole chiare non è un limite, è un acceleratore di fiducia.

Elimina l’incertezza e ti permette di investire sapendo esattamente dove stai andando.

L’AI Act non è un muro; è il guardrail che definisce la strada, permettendo a chiunque di percorrerla in modo sicuro e strategico.

In questo articolo, zero allarmismi

Solo un piano d’azione per trasformare un obbligo in un vantaggio competitivo.

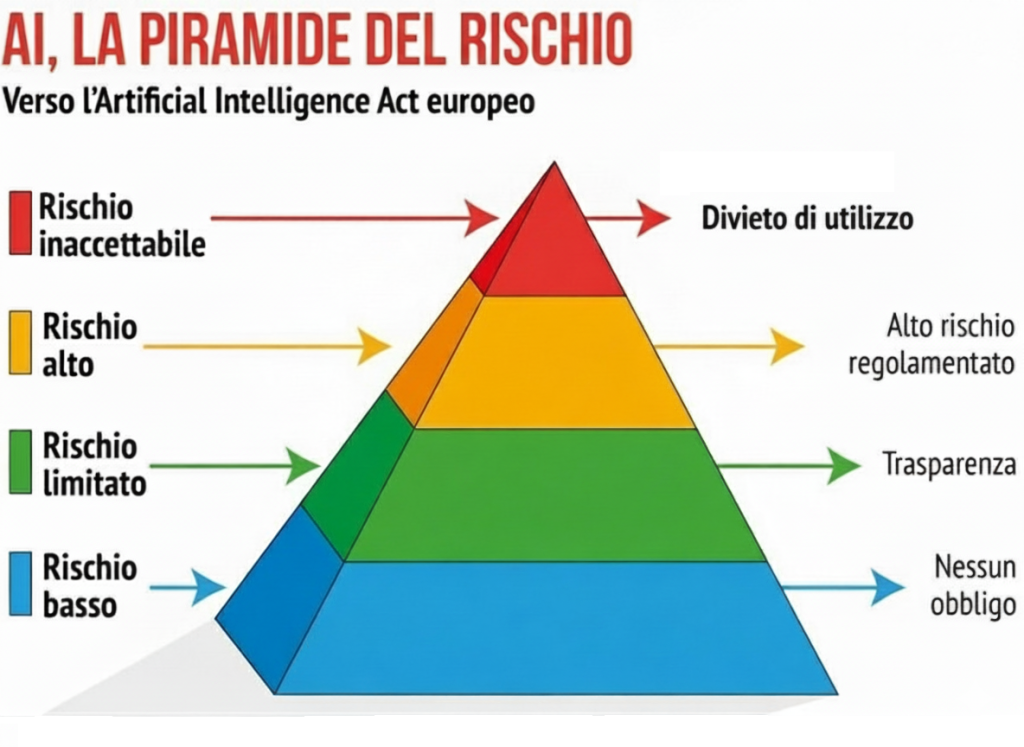

La Piramide del Rischio: 4 Livelli per capire subito dove sei

Il cuore dell’AI Act è un approccio a strati, semplice e intuitivo.

Immagina una piramide con 4 livelli di rischio.

La tua prima domanda deve essere una sola: “Il mio sistema AI, dove si colloca?”.

LIVELLO 1: Rischio Inaccettabile (semplicemente, NON si fa)

Partiamo da ciò che è completamente off-limits. Roba da film di fantascienza distopico. Pratiche considerate contrarie ai nostri valori e quindi vietate (Art. 5, AI Act). Stiamo parlando di:

- Manipolazione occulta: AI che, di nascosto, spingono a comportamenti dannosi.

- Sfruttamento di vulnerabilità: AI progettate per approfittare di bambini o persone fragili.

- Social Scoring: Sistemi che assegnano un “punteggio sociale” ai cittadini.

- Identificazione biometrica in tempo reale e indiscriminata: Il “Grande Fratello” negli spazi pubblici, vietato salvo eccezioni strettissime per le forze dell’ordine.

Bottom line: Se non stai complottando per dominare il mondo dal tuo garage, questo livello non ti riguarda. Avanti.

LIVELLO 2: Rischio Alto (il cuore della nuova strategia)

Ecco dove casca l’asino per la maggior parte delle aziende serie. Essere “alto rischio” non significa “pericoloso”, ma “importante”. Significa che il tuo sistema AI prende decisioni con un impatto significativo sulla vita delle persone. E per questo, deve essere “fatto bene”: affidabile, giusto e trasparente.

Le aree principali, come elencate nero su bianco nell’Allegato III dell’AI Act, sono:

- Risorse Umane: L’AI per il recruiting, l’analisi dei CV, la valutazione delle performance.

- Accesso al Credito: Sistemi che valutano l’affidabilità creditizia di una persona.

- Istruzione: Piattaforme che decidono l’ammissione a un corso o valutano un esame.

- Accesso a Servizi Essenziali: Sia pubblici (es. bonus sociali) che privati, come i sistemi per la valutazione del rischio e la fissazione dei prezzi nelle assicurazioni sulla vita e sulla salute.

Essere qui non è una condanna. È una medaglia di serietà se la gestisci bene!

LIVELLO 3: Rischio Limitato (la Regola d’Oro della Trasparenza)

Questa è l’altra categoria chiave per il business. Qui il rischio non è il danno, è l’inganno. La soluzione è una sola: trasparenza (Art. 50, AI Act).

- Chatbot: Deve dire “Ciao, sono un assistente virtuale”.

- Contenuti Generati (Deepfake): Un’immagine creata con l’AI che sembra reale? Va etichettata.

- Riconoscimento Emotivo: Stai usando un’AI per analizzare le emozioni? Devi informare le persone.

Non è un peso, è marketing intelligente.

LIVELLO 4: Rischio Minimo (La zona franca dell’Innovazione)

Qui rientra il 90% delle applicazioni AI che usiamo ogni giorno: filtri anti-spam, motori di raccomandazione, assistenti alla scrittura di codice. Per questi sistemi, l’AI Act non impone alcun obbligo. Libertà totale.

La Distinzione Cruciale: L’AI Act giudica lo Strumento, il GDPR Protegge il Dato

Un dubbio che sento spesso: “Ma un’AI che registra le call è solo a rischio limitato? E se lì dentro ci finiscono dati sensibilissimi?”.

Questa è LA domanda chiave. E la risposta svela la logica di tutto:

- L’AI Act valuta la FUNZIONE, non il DATO. Il regolamento non classifica i sistemi in base ai dati che trattano o potrebbero trattare, ma in base alla loro funzione specifica e alla finalità d’uso.

La sua domanda è: “Cosa fa questo strumento e quanto è impattante la sua funzione sulla vita delle persone?”. - Il GDPR valuta il DATO, non lo STRUMENTO. Al GDPR non interessa la tecnologia, ma il dato personale. La sua domanda è: “Stai trattando dati di persone? Hai il permesso? Li stai proteggendo?”

In sintesi: l’AI Act si occupa del RISCHIO DELLO STRUMENTO, il GDPR del RISCHIO DEL DATO.

Questo significa che uno strumento può essere a rischio minimo per l’AI Act, ma il suo utilizzo può essere ad altissimo rischio per il GDPR. I due regolamenti sono complementari e vanno rispettati entrambi.

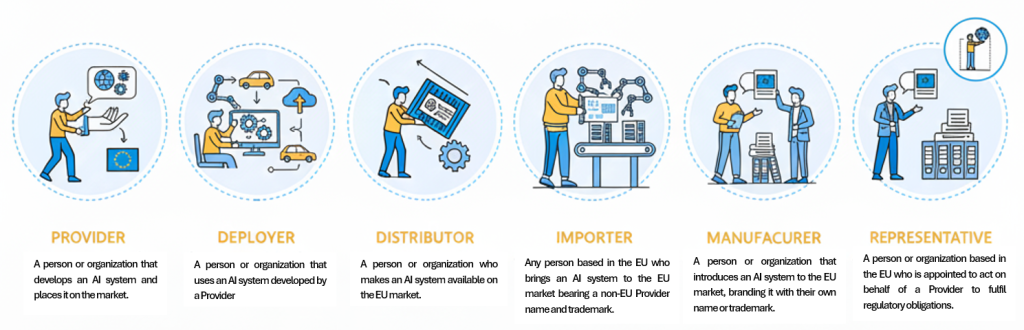

I Ruoli del Gioco: La Squadra al Completo

Capire il tuo ruolo è fondamentale per sapere quali regole seguire.

- Il Fornitore (Provider): Il Regista.

Sei tu che hai avuto la visione, hai sviluppato il sistema AI e lo immetti sul mercato con il tuo nome. Quando il prodotto esce, la responsabilità della sua conformità è tua. Dalla progettazione alla documentazione, dal monitoraggio post-vendita alla conformità, sei tu che ci metti la faccia. Punto. (Art. 3, n.3). - Il Produttore di Prodotti (Product Manufacturer): L’Assemblatore Finale (che si prende tutta la responsabilità).

Questo è il ruolo che frega il 90% delle aziende manifatturiere. Sei un’azienda che fa un prodotto fisico. Se prendi un componente AI (magari da un Fornitore esterno) e lo integri nel tuo prodotto finale, l’AI Act ti dice una cosa molto chiara: per la legge, assumi tu gli obblighi del Fornitore per quel componente AI (Art. 25, par. 3).

Questo scatta quando l’AI è un componente di sicurezza di un prodotto che rientra nelle normative europee elencate nell’Allegato I dell’AI Act. Parliamo di roba seria: sistemi di intelligenza artificiale utilizzati in prodotti come giocattoli, automobili, dispositivi medici, ascensori o dispositivi di protezione individuale, ecc. La logica è brutale: se metti il tuo marchio sul prodotto finale, la responsabilità del pacchetto completo è tua. Non puoi scaricare la colpa sul fornitore del singolo chip. - L’Utilizzatore (Deployer): Il Pilota.

Sei l’azienda o il professionista che usa un sistema AI per la propria attività. Non l’hai costruito tu, ma sei tu che premi il pulsante. La tua responsabilità è usarlo con la testa, seguire le istruzioni, garantire che un umano abbia sempre l’ultima parola e, nei casi ad alto rischio, valutare l’impatto che avrà nel tuo specifico contesto. (Art. 3, n.4). - L’Importatore (Importer): Il Buttafuori dell’Europa.

Sei il primo che immette sul mercato europeo un sistema AI prodotto da un’azienda extra-UE. Il tuo compito è fare da garante. Prima di far entrare quel prodotto, devi verificare che il fornitore estero abbia fatto tutti i compiti a casa: valutazione di conformità, documentazione, marchio CE. Se non è in regola, non entra. (Art. 3, n.6). - Il Distributore (Distributor): Il Rivenditore.

Non hai costruito l’AI, non l’hai importata, la vendi soltanto. La tua responsabilità è più leggera, ma non è zero. Prima di metterla a scaffale, devi fare un controllo “visivo”: ha il marchio CE? Ha le istruzioni? Se sembra tutto a posto, procedi. Se qualcosa puzza, ti fermi e segnali. (Art. 3, n.7). - Il Rappresentante Autorizzato (Authorised Representative): L’Ambasciatore.

Sei la faccia, il nome e il numero di telefono in Europa per un fornitore che sta dall’altra parte del mondo. Agisci per suo conto, conservi la documentazione e sei il primo contatto per le autorità. Un ruolo di fiducia e di grande responsabilità. (Art. 3, n.5).

Il Piano d’Azione in 3 Step

Basta chiacchiere. Passiamo all’azione.

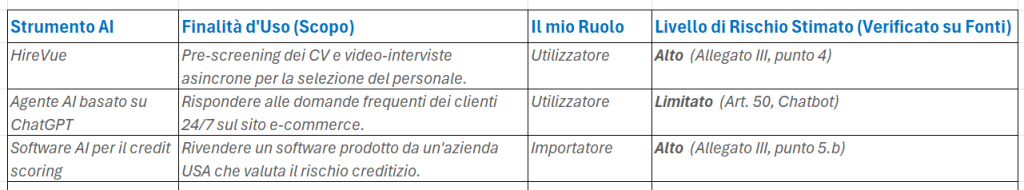

STEP 1: La Mappatura (La Tua Bussola Strategica)

Azione Concreta: Crea un foglio Excel e compilalo onestamente. (vedi un esempio qui sotto)

Qui puoi scaricare il file di esempio:

STEP 2: Gestire i Rischi (lo schema operativo)

Per l’Alto Rischio:

- Se sei un FORNITORE: Il tuo mantra è qualità e documentazione.

- Sistema di Gestione del Rischio (Art. 9): Un processo continuo per analizzare, mitigare e documentare i rischi.

- Qualità dei Dati (Art. 10): Dati di training impeccabili, senza bias.

- Documentazione Tecnica (Art. 11): Crea il “libretto di uso e manutenzione” del tuo AI.

- Se sei un UTILIZZATORE: Il tuo mantra è uso consapevole e controllo.

- Chiedi le Istruzioni (Art. 13): Il Fornitore DEVE darti un manuale chiaro. Leggilo e seguilo.

- Forma il Tuo Team: La supervisione umana richiede competenza. Investi in alfabetizzazione sull’AI.

- Valutazione d’Impatto (Art. 27): Se sei un ente pubblico o un’azienda che offre servizi essenziali, è un passaggio obbligato.

Per il Rischio Limitato:

- L’unica azione è: implementa la trasparenza. Un banner, un pop-up, un messaggio chiaro.

Conclusione: Un Vantaggio Competitivo, non una Tassa

L’AI Act non è una tassa sull’innovazione. È un investimento sulla fiducia.

Le aziende che si adeguano non stanno solo rispettando una legge. Stanno dicendo al mercato: “Di noi ti puoi fidare. I nostri strumenti sono seri, equi e trasparenti”. In un mondo inondato di AI, la fiducia sarà la merce più preziosa.

E allora, come trasformare queste regole in un vantaggio strategico? La differenza tra chi subirà questo cambiamento e chi lo guiderà si decide nelle risposte che si danno oggi.